Beneficios y riesgos de la inteligencia artificial para el sector público y las personas en Iberoamérica: la cuestión de los sesgos

Juli Ponce Solé

Catedrático de Derecho Administrativo, Universidad de Barcelona

Hace unas semanas, el Banco Interamericano de Desarrollo (BID) se preguntaba lo siguiente: ¿Puede América Latina y el Caribe liberar el potencial de la inteligencia artificial y mitigar sus riesgos? Les sugerimos la lectura del breve artículo al respecto, que creemos plantea bien en su título la esencia de la llamada cuarta revolución industrial en marcha, con efectos, como gusta de decirse ahora disruptivos: la aportación de beneficios y los riesgos de posibles costes que pueda generar, beneficios y costes que nosotros vamos a considerar muy brevemente aquí para centrarnos, dentro de los segundos, en el riesgo que presentan los sesgos de la Inteligencia Artificial (IA).

Las ventajas de la IA parecen, desde luego, indudables: una capacidad de procesamiento mucho mayor que los humanos (cuya memoria es mucho más limitada y se ve afectada por la fatiga), la capacidad de realizar predicciones mediante correlaciones, mayor eficacia, eficiencia y, por tanto, buena administración, la posibilidad de evitar los sesgos cognitivos de los humanos y de acabar con el ruido, esto es la existencia de decisiones distintas no queridas en condiciones similares y la capacidad de generar nuevas ocupaciones laborales relacionadas.

Ahora bien, en todo caso no hay que olvidar los problemas que también puede generar la IA y que hemos considerado en otro momento: desde la substitución de humanos en tareas privada y públicas con el consiguiente desempleo, pasando por el hecho de que las correlaciones generadas por la IA pueden dar lugar a errores (o alucinaciones) y que dichas correlaciones tienen una tendencia conservadora, al primar el status quo, puesto que se extraen predicciones de lo que ocurrió en el pasado, pero el pasado, y las personas, pueden cambiar. Los mencionados errores pueden existir también en la programación (bugs), que pueden tener un impacto a gran escala, afectando a muchas más personas que una decisión adoptada por un humano.

Además, como es sabido, en el caso de los sistemas de aprendizaje automático y profundo, propios de la IA no simbólica, estadística o basada en datos, éstos presentan el problema de las llamadas cajas negras. La complejidad de estos sistemas de toma de decisiones hace difícil explicar los pasos seguidos hasta la toma de la decisión final, lo que plantea cuestiones jurídicamente relevantes, relativas al control del seguimiento del debido proceso, en términos de interdicción de la arbitrariedad (recogida en el art. 9.3 de la Constitución española, por ejemplo), es decir la prohibición de decisiones irracionales o no motivadas, y también de buena administración, esto es la exigencia de decisiones fruto del respeto de la obligación jurídica de debido cuidado o debida diligencia en la toma de la decisión final, que hemos analizado aquí, la cual debe haber considerado todos los factores relevantes y descartado los irrelevantes. Está aún por ver si estas mismas técnicas podrán dar iguales frutos en relación con el proceso de toma de decisiones de la IA y sus cajas negras.

Ahora bien, siendo cierto todo ello, y aún otros problemas, como el que aludiremos más tarde de posible manipulación, la limitación jurídica por los humanos del uso de la IA se basaría en algo mucho más profundo aún. La doctrina jurídica y normativa que se ocupan del tema mencionan los conceptos de dignidad humana y posible violación de derechos, como en este segundo caso hace el art. 14 de la propuesta de Reglamento de la Unión Europea de IA (en adelante, RUEIA), lanzada en 2021, en proceso avanzado de negociación política y aprobación al escribir estas líneas, para justificar la “desconfianza” humana en la IA, debido, como dice este precepto, a “los riesgos para la salud, la seguridad o los derechos fundamentales que pueden surgir cuando un sistema de IA de alto riesgo se utiliza conforme a su finalidad prevista o cuando se le da un uso indebido razonablemente previsible, en particular cuando dichos riesgos persisten a pesar de aplicar otros requisitos…”.

Cabe formular entonces una pregunta clave ¿por qué un sistema algorítmico en su caso con IA puede afectar a la dignidad de la persona o violar sus derechos de un modo específico en que no lo puede hacer un humano? En nuestra opinión, expuesta en otro lugar, en el caso de las potestades discrecionales de las Administraciones Públicas, el empleo de IA estadística, que carece de empatía humana, para su ejercicio totalmente automatizado debería implicar un límite jurídico a tener en cuenta, ligado al derecho a una buena administración, límite que exigiría la implantación legal de una reserva de humanidad para ciertos cometidos públicos.

La existencia de beneficios y riesgos considerables está llevando a aceptar paulatinamente la necesidad de no fiar el encauzamiento de la IA sólo a la ética y a reivindicar el papel imprescindible del Derecho en la protección de derechos e intereses legítimos de las personas, un Derecho que puede y debe respetar la innovación tecnológica y el funcionamiento del mercado a la vez que proporciona seguridad jurídica imprescindible para el buen funcionamiento de éste. Con más detalle nos hemos referido a esta cuestión aquí. La propuesta aludida del RUEIA es un buen indicador de lo expuesto.

Centrándonos ahora y aquí brevemente en los mencionados sesgos, cabe avanzar que no es cierto que la IA esté libre de sesgos, pues sesgos existen en la mente de los programadores, en los datos manejados para entrenar a la IA y para que esta decida o estadísticos, así como en los humanos encargados de su control, como veremos enseguida.

La aprobación de la Ley española 15/2022, de 12 de julio, integral para la igualdad de trato y la no discriminación ha traído al Derecho en vigor una alusión a los sesgos de la IA en su artículo 23:

Artículo 23. Inteligencia Artificial y mecanismos de toma de decisión automatizados.

1. En el marco de la Estrategia Nacional de Inteligencia Artificial, de la Carta de Derechos Digitales y de las iniciativas europeas en torno a la Inteligencia Artificial, las administraciones públicas favorecerán la puesta en marcha de mecanismos para que los algoritmos involucrados en la toma de decisiones que se utilicen en las administraciones públicas tengan en cuenta criterios de minimización de sesgos, transparencia y rendición de cuentas, siempre que sea factible técnicamente. En estos mecanismos se incluirán su diseño y datos de entrenamiento, y abordarán su potencial impacto discriminatorio. Para lograr este fin, se promoverá la realización de evaluaciones de impacto que determinen el posible sesgo discriminatorio.

Como vemos, pues la ley española alude a los sesgos, pero no los define. De ahí que sea tan importante acudir a otras ciencias, para no cometer un posible y trágico error: entender que un sesgo implica discriminación siempre y que, por tanto, si no hay discriminación, no hay sesgo. Pues, siguiendo el juego de palabras, ocurre que puede existir sesgo y no discriminación, al igual que puede existir discriminación sin sesgo.

De forma implícita, en los medios de comunicación y también en el mundo jurídico, cuando se habla de sesgo se entiende que hay una discriminación por violación del derecho a la igualdad. Pero las cosas no son tan simples.

Efectivamente, en Derecho iberoamericano, la palabra sesgo parece que no ha tenido tradicionalmente un papel destacado, a diferencia de otros derechos, donde el concepto de sesgo sí tiene un significado jurídico (como bias, en Derecho angloamericano). De hecho, si buscamos sesgo en el Diccionario Panhispánico del Español Jurídico, este termino no aparece.

Si lo hacemos en el Diccionario de la RAE, aparece la palabra sesgo con las siguientes acepciones:

1. adj. Torcido, cortado o situado oblicuamente.

2. adj. Grave, serio en el semblante.

3. adj. p. us. quieto (‖ pacífico, sosegado).

4. m. Oblicuidad o torcimiento de una cosa hacia un lado, o en el corte, o en la situación, o en el movimiento.

5. m. Corte o medio término que se toma en los negocios dudosos.

6. m. Curso o rumbo que toma un negocio.

7. m. Estad. Error sistemático en el que se puede incurrir cuando al hacer muestreos o ensayos se seleccionan o favorecen unas respuestas frente a otras.

8. f. nesga.

al sesgo

1. loc. adv. oblicuamente.

Ante esta falta de significado específico jurídico, otras ciencias si han usado históricamente la palabra sesgo. Así, cabe destacar el uso que de este término que se realiza en la psicología cognitiva, y su adopción en la Economía y el Derecho conductuales, como hemos destacado en en otro momento, que definen al sesgo como un error sistemático de la mente al emplear heurísticos o atajos cognitivos.

Desde esta perspectiva conductual, no cabe contraponer los sesgos cognitivos humanos a su supuesta ausencia en los programas informáticos y en los supervisores del buen funcionamiento de la IA. Porque, en primer lugar, los sesgos cognitivos humanos de los programadores, que pueden ser inconscientes, pueden traspasarse a los algoritmos. Dichos sesgos no sólo pueden producir discriminación, sino que el panorama es más rico y complicado: sesgos como el de disponibilidad o del de confirmación pueden provocar que la información seleccionada para nutrir el sistema no sea discriminatoria quizás, pero en todo caso, no será la adecuada para obtener un buen funcionamiento. Más aún, la IA produce un sesgo cognitivo humano específico y bien estudiado: el sesgo de automatización, por el que, en general, los humanos tendemos a confiar en lo que nos dicen los sistemas empleados y rara vez lo cuestionamos, lo que puede dar lugar a supuestos extremos como las llamadas muertes por GPS: personas pérdidas en el desierto que mueren por seguir a rajatabla las equivocadas indicaciones del navegador. Este sesgo de automatización es especialmente peligroso en el control de la IA por los humanos (supervisión o human in the loop).

Además, en segundo lugar, los datos con que se alimenta el sistema probablemente estarán sesgados, como lo está nuestra sociedad, por lo que, en el caso de sistemas de aprendizaje automático, el sistema va a usar datos sesgados y además se va a sesgar conforme “aprenda” autónomamente. Aquí es de aplicación la conocida frase en este ámbito relativa a que “si entra basura, sale basura” (garbage in garbage out). El sesgo de los datos no solo tiene relación con los sesgos sociales preexistentes (machismo, racismo…) sino que además se ve reforzado por el hecho de los conjuntos de datos que se emplean en programación provienen de un puñado deinstituciones, muchas de ellas corporativas occidentales. En concreto, los estudios disponibles ponen de relieve que hay una creciente desigualdad en el uso de conjuntos de datos a nivel mundial, y que más del 50% de todos los usos de conjuntos de datos en la muestra empleada correspondieron a conjuntos de datos introducidos por doce instituciones de élite, principalmente occidentales, como la Universidad de Stanford, Microsoft, Princeton, Facebook, Google, el Instituto Max Planck y AT&T, siendo cuatro de las diez principales fuentes de conjuntos de datos provenientes de instituciones corporativas

Por otro lado, la Estadística también emplea la palabra sesgo con un significado específico. Además, pues, pueden producirse sesgos estadísticos a añadir a los anteriores, cognitivos y de datos. El sesgo estadístico es una inclinación sistemática que está presente en el proceso de recopilación de datos y que da lugar a resultados desviados y engañosos, que hacen divergente la teoría y la realidad. Este sesgo puede aparecer por diversas razones. Así, por la manera de seleccionar la muestra, siendo la aleatoriedad la clave para reducir ese posible sesgo. También por la manera de recopilar los datos, conectando con lo que dijimos antes sobre los datos sesgados.

En consecuencia, pueden existir sesgos cognitivos humanos, de disponibilidad (el programador atiende a la información más disponible descartando otras), de confirmación (el programador toma en consideración sólo información que confirma su visión del mundo), de automatización (el programador o el usuario confían excesivamente en el correcto funcionamiento de la IA), que influyan en el uso de la Inteligencia Artificial, no provocando necesariamente discriminación alguna, pero si un uso inadecuado de ésta y posibles violaciones del ordenamiento jurídico, por ejemplo en el ámbito público, por no tener en cuenta el sistema todos los hechos relevantes para la toma de la decisión.

Por tanto, el mensaje es sencillo: los sesgos son negativos, incluso pueden dar lugar a ilegalidades, pero no siempre ni necesariamente a discriminaciones.

Por último, es preciso destacar que los sesgos son errores sistemáticos y predecibles de nuestro cerebro, que no tienen porqué ser inducidos por nadie más. Esto es, nuestra mente nos engaña a nosotros mismos por sí sola. Pero tampoco hay que descartar que ese engaño sí sea inducido por otros, esto es que se nos manipule para explotar nuestros sesgos.

Esta es una cuestión que, como hemos tenido ocasión de exponer en otro momento, es un problema que preocupa a instituciones como el Comité de Ministros del Consejo de Europa, que en una declaración de 13 de febrero de 2019 ha alertado sobre el riesgo aquí apuntado (Declaration by the Committee of Ministers on the manipulative capabilities of algorithmic processes, Adopted by the Committee of Ministers on 13 February 2019 at the 1337 meeting of the Ministers’ Deputies).

Aquí, de nuevo, el Derecho y la regulación tienen un papel importante para evitar dicha manipulación, como sucede en el caso del uso de los llamados patrones oscuros (dark patterns), diseños de interfaz que buscan confundir y manipular al consumidor o usuario, que pueden ser potenciados por la IA, fenómeno al que también hemos hecho aquí referencia, y que ha sido ya objeto de prohibición por diversas normativas en el mundo, como, por ejemplo, la legislación de California ( California Privacy Rights Act (CPRA), del año 2020) y de la Unión Europea.

En el segundo caso es relevante el reciente Reglamento (UE) 2022/2065 del Parlamento Europeo y del Consejo de 19 de octubre de 2022 relativo a un mercado único de servicios digitales y por el que se modifica la Directiva 2000/31/CE (Reglamento de Servicios Digitales), como antes avanzábamos.

En concreto, el art. 25 del Reglamento de Servicios Digitales señala ahora lo siguiente:

“Artículo 25

Diseño y organización de interfaces en línea

1. Los prestadores de plataformas en línea no diseñarán, organizarán ni gestionarán sus interfaces en línea de manera que engañen o manipulen a los destinatarios del servicio o de manera que distorsionen u obstaculicen sustancialmente de otro modo la capacidad de los destinatarios de su servicio de tomar decisiones libres e informadas.

2. La prohibición del apartado 1 no se aplicará a las prácticas contempladas en la Directiva 2005/29/CE o en el Reglamento (UE) 2016/679.

3. La Comisión podrá publicar directrices sobre cómo el apartado 1 se aplica a prácticas específicas, en particular:

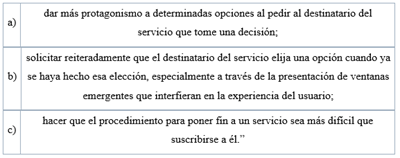

El Considerando 67 del Reglamento señala respecto a los patrones oscuros (que denomina “interfaces engañosas” en traducción que pretende ser literal de la expresión “dark patterns” incluida en la versión oficial inglesa) lo siguiente

“Las interfaces engañosas de las plataformas en línea son prácticas que distorsionan o merman sustancialmente, de forma deliberada o efectiva, la capacidad de los destinatarios del servicio de tomar decisiones autónomas y con conocimiento de causa”.

Tras esta definición, el considerando se centra los efectos de estas “interfaces engañosas”:

“Estas prácticas pueden utilizarse para persuadir a los destinatarios del servicio de que adopten comportamientos no deseados o decisiones no deseadas que tienen consecuencias negativas para ellos. Por esta razón, debe prohibirse a los prestadores de plataformas en línea engañar o empujar en esta dirección a los destinatarios del servicio y distorsionar u obstaculizar la autonomía, la toma de decisiones o la capacidad de elección de los destinatarios del servicio a través de la estructura, el diseño o las funcionalidades de una interfaz en línea o una parte de esta.”

Asimismo, se indica que:

“Entre estas prácticas se han de incluir, entre otras, las opciones de diseño abusivas que dirigen al destinatario hacia acciones que benefician al prestador de plataformas en línea, pero que pueden no favorecer los intereses de los destinatarios, al presentar opciones de una manera que no es neutra, por ejemplo, dando más protagonismo a determinadas opciones mediante componentes visuales, auditivos o de otro tipo, cuando se le pide al destinatario del servicio que tome una decisión.

Otras prácticas que también deben estar incluidas son solicitar repetidamente al destinatario del servicio que tome una decisión cuando esa decisión ya ha sido tomada, hacer que el procedimiento de anulación de un servicio sea considerablemente más engorroso que la suscripción a dicho servicio, hacer que determinadas opciones sean más difíciles o lleven más tiempo que otras, dificultar excesivamente la interrupción de las compras o la desconexión de una plataforma en línea determinada que permite a los consumidores celebrar contratos a distancia con comerciantes, y engañar a los destinatarios del servicio empujándoles a tomar decisiones sobre transacciones o mediante ajustes por defecto que sean muy difíciles de cambiar, dirigiendo de forma injustificada la toma de decisiones del destinatario del servicio, de manera que se distorsione y merme su autonomía, su toma de decisiones y su capacidad de elección.”

En todo caso:

“Sin embargo, las normas contra las interfaces engañosas no deben entenderse en el sentido de que impidan a los prestadores interactuar directamente con los destinatarios del servicio y ofrecerles servicios nuevos o adicionales. Las prácticas legítimas, como las publicitarias, que sean conformes con el Derecho de la Unión no deben considerarse en sí mismas interfaces engañosas. Dichas normas sobre interfaces engañosas deben interpretarse en el sentido de que se aplican a las prácticas prohibidas que entran en el ámbito de aplicación del presente Reglamento en la medida en que no estén ya cubiertas por la Directiva 2005/29/CE o el Reglamento (UE) 2016/679.”

Partiendo de estos considerandos, como hemos visto, el nuevo art. 25 del Reglamento de la Unión Europea de Servicios Digitales prohíbe dichos patrones oscuros y anuncia la posibilidad de que la Comisión elabore directrices al respecto, lo que, sin duda, puede ser de utilidad para precisar qué prácticas y en qué contexto suponen una explotación prohibida de los sesgos de las personas. En definitiva, respondiendo a la pregunta con que iniciábamos este artículo (¿Puede América Latina y el Caribe liberar el potencial de la inteligencia artificial y mitigar sus riesgos?), creemos que sí, siempre que la regulación jurídica sea adecuada y los gestores públicos tengan suficiente conocimiento sobre el funcionamiento de la IA. Queda tarea, pues, por delante, y en la misma, el mutuo enriquecimiento entre Iberoamérica y Europa debería ser prioritario en la misma.